Dans le développement web, l’expérience utilisateur et la performance des applications sont au cœur des attentes. Aussi, choisir les bons outils technologiques est essentiel pour garantir la réussite d’un projet. Symfony UX se présente comme une solution attrayante, relativement nouvelle, qui combine la robustesse du framework Symfony avec des outils front-end modernes, offrant ainsi un écosystème complet pour développer des applications. Cet article explore donc les avantages de développer un projet avec Symfony UX, en passant en revue les points forts, les bénéfices en termes de productivité et de maintenance, ainsi que les perspectives qu’il ouvre.

Une intégration harmonieuse entre back-end et front-end

L’un des atouts majeurs de Symfony UX réside dans sa capacité à rapprocher le monde du back-end et du front-end de manière simple. Le développement d’applications web nécessite souvent de jongler entre des technologies distinctes pour gérer le serveur et l’interface utilisateur. Avec Symfony UX, cette barrière s’efface, permettant aux développeurs de créer une expérience utilisateur riche sans pour autant sacrifier la cohérence du code.

Un développement unifié

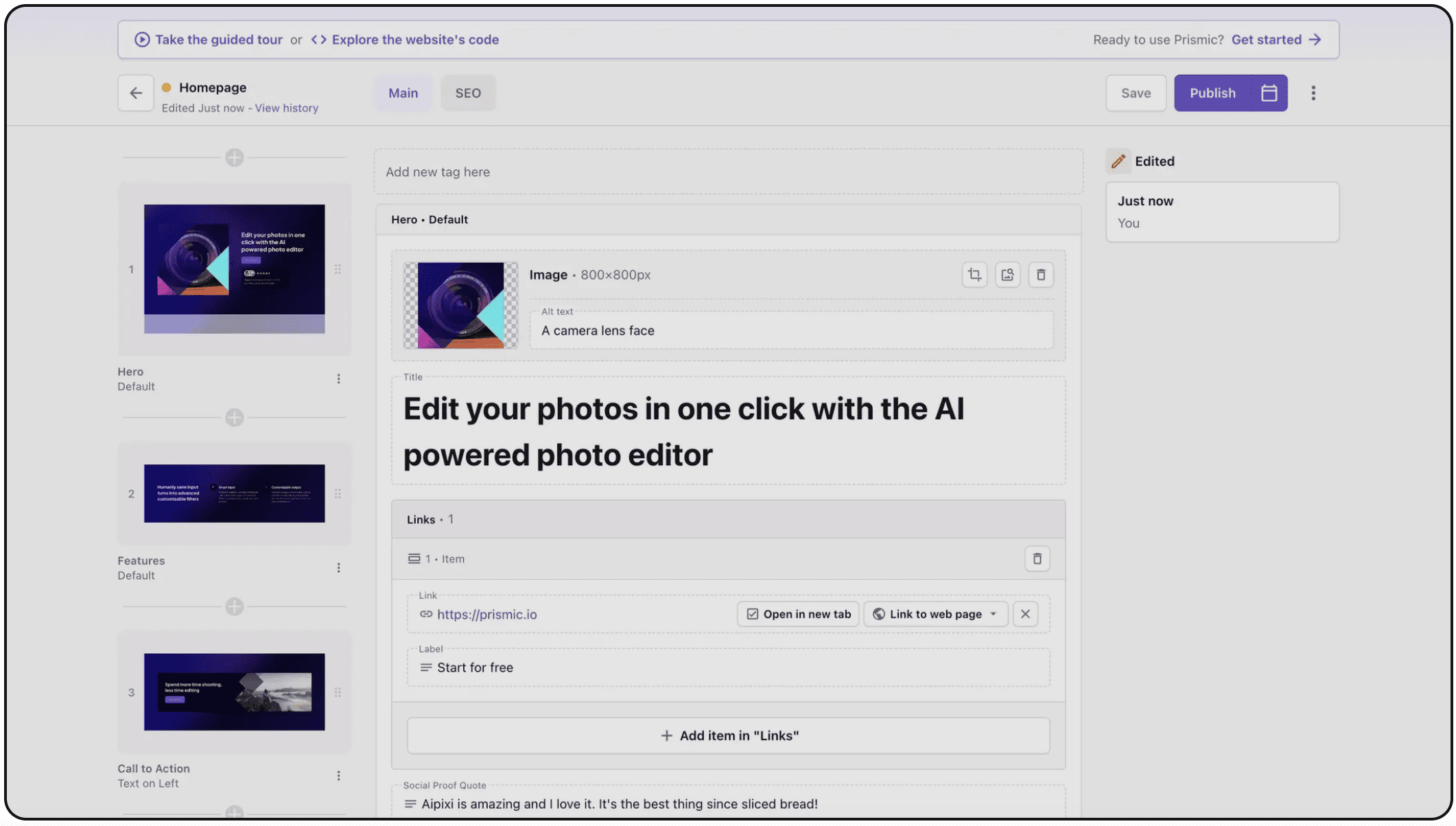

Symfony UX offre un environnement de développement complet qui intègre directement des bibliothèques JavaScript telles que Stimulus et Turbo. Ces outils permettent le développement d’interactions assez riches sans avoir à recourir à des frameworks front-end lourds. Par exemple, Stimulus, qui est le framework JavaScript intégré dans Symfony UX, permet de structurer le code front-end en respectant le principe de l’« unobtrusive JavaScript », c’est-à-dire que le code JavaScript s’intègre discrètement dans les pages HTML sans perturber la structure du document.

Cette intégration offre aussi une courbe d’apprentissage beaucoup plus linéaire pour les équipes habituées à Symfony. Les développeurs peuvent ainsi se concentrer sur l’implémentation de la logique métier et de l’expérience utilisateur, plutôt que de devoir gérer des configurations complexes et des transitions entre les différents environnements.

Productivité et rapidité de développement

L’un des principaux avantages de Symfony UX est donc l’accélération potentielle du développement des projets. Notamment grâce :

A la réduction des tâches répétitives

Dans un projet classique, la gestion des comportements dynamiques nécessite souvent l’écriture de beaucoup de code JavaScript. Symfony UX, avec ses composants comme Stimulus et Turbo, permet de réduire le coût de ces tâches. Par exemple, Turbo offre des mécanismes de rafraîchissement partiel de pages et une navigation plus fluide, sans nécessiter de rechargement complet du navigateur.

Une meilleure collaboration entre équipes

Le fait que Symfony UX repose sur des technologies courantes et bien documentées facilite également la collaboration entre les équipes front-end et back-end. Lorsque les deux équipes travaillent sur le même langage et le même framework, les échanges sont plus simples, ce qui conduit à une meilleure cohésion de l’ensemble du projet. Les développeurs front-end peuvent, par exemple, tirer parti de l’architecture de Stimulus pour structurer leurs composants, tandis que les développeurs back-end profitent de la puissance de Symfony pour gérer les aspects complexes de la logique métier et de l’accès aux données.

Des outils de développement

Symfony UX intègre également des outils de développement modernes qui améliorent la productivité globale. La gestion des assets via Webpack Encore, par exemple, simplifie le processus de compilation et de gestion des fichiers JavaScript et CSS. Cela permet de se concentrer sur le développement de fonctionnalités plutôt que sur la configuration de l’environnement de build. De plus, l’utilisation de Stimulus pour orchestrer le comportement du front-end permet de maintenir un code propre et modulable, réduisant ainsi le temps consacré au débogage et à la maintenance.

Une approche modulaire et évolutive

L’un des défis majeurs dans le développement de projets web est aussi la capacité à faire évoluer l’application au fil du temps sans compromettre sa stabilité. Symfony UX répond à ce défi en adoptant une approche modulaire, permettant d’ajouter ou de modifier des fonctionnalités de manière progressive et contrôlée.

Un écosystème de composants réutilisables

Symfony UX encourage l’utilisation de composants réutilisables. Les modules (comme Stimulus) permettent de créer des contrôleurs JavaScript encapsulés qui peuvent être facilement réutilisés dans différentes parties de l’application. Cette modularité se traduit par une diminution des redondances dans le code et une amélioration de la maintenabilité à long terme.

Facilité d’intégration des mises à jour

Le développement avec Symfony UX bénéficie également d’une intégration facilitée des mises à jour. Symfony étant un framework mature et constamment amélioré, les mises à jour de sécurité et les nouvelles fonctionnalités sont régulièrement publiées. La nature modulaire de Symfony UX permet d’intégrer ces mises à jour sans devoir réécrire l’ensemble de l’application. Cela garantit non seulement la sécurité de l’application, mais aussi sa compatibilité avec les nouvelles technologies et standards du web.

Optimisation des performances et expérience utilisateur

Chargement et navigation optimisés

L’un des avantages notables de Turbo, composant phare de Symfony UX, est sa capacité à optimiser la navigation au sein d’une application web. En évitant le rechargement complet des pages et en ne mettant à jour que les parties nécessaires, Turbo réduit considérablement le temps de chargement perçu par l’utilisateur. Cette approche conduit à une expérience de navigation très réactive.

Réduction de la charge serveur

En permettant des mises à jour partielles du contenu, Symfony UX contribue aussi à réduire la charge sur le serveur puisque l’application peut se contenter de renvoyer uniquement les données nécessaires.

Une interactivité sans compromis

Stimulus permet de gérer des comportements interactifs simples à complexes en s’appuyant sur une logique claire et une syntaxe minimaliste. Cette approche garantit que l’interactivité ne vient pas alourdir le chargement initial de la page et que les interactions ultérieures restent fluides, même sur des appareils moins performants.

Sécurité et robustesse

Meilleures pratiques intégrées

Symfony UX dispose également d’un socle sécurisé et robuste grâce à Symfony. Symfony est reconnu pour ses bonnes pratiques en matière de sécurité. Le framework intègre des mécanismes de protection contre les attaques courantes telles que les injections SQL, les attaques XSS (Cross-Site Scripting) ou CSRF (Cross-Site Request Forgery). En utilisant Symfony UX, les développeurs héritent de ces dispositifs de sécurité.

Contrôle fin des accès et authentification

Un autre point fort de Symfony UX réside dans sa compatibilité avec les outils de gestion des utilisateurs et des accès, notamment grâce à des bundles dédiés pour l’authentification et l’autorisation. La gestion centralisée des règles de sécurité permet de s’assurer que seules les personnes autorisées ont accès aux données sensibles de l’application. Ceci est particulièrement important dans des projets d’envergure où la confidentialité et l’intégrité des données représentent des enjeux majeurs.

Cas pratiques et retours d’expérience

Un gain de temps significatif

Notre expérience montre que l’utilisation de Symfony UX permet de réduire les délais de développement. En centralisant la logique métier et en simplifiant l’implémentation du front-end, les équipes de développement ont pu se concentrer sur l’essentiel : répondre aux besoins des utilisateurs finaux. Ce gain de temps se traduit également par une réduction des coûts de développement et une mise sur le marché plus rapide des produits.

Une meilleure expérience utilisateur

Les projets développés avec Symfony UX se distinguent par une interface fluide et réactive. L’intégration de Turbo pour la navigation sans rechargement complet des pages, associée à l’efficacité de Stimulus pour la gestion des interactions, permet de proposer une très bonne expérience utilisateur. Les utilisateurs bénéficient ainsi d’une application web dont la réactivité et la performance sont optimisées, même en cas de forte affluence ou sur des appareils moins puissants.

Une maintenance facilitée

Enfin, Symfony UX facilite la maintenance des projets. Grâce à la structure modulaire et à la documentation claire du framework, il est plus simple pour les équipes de reprendre le code existant, de corriger d’éventuels bugs ou d’ajouter de nouvelles fonctionnalités sans compromettre la stabilité de l’application.

Mais il faut bien des cas où cela ne marche pas vraiment !

Bien que Symfony UX offre de nombreux avantages, il n’est pas toujours adapté à tous les types de projets. Par exemple, des frameworks JavaScript spécialisés comme React, Vue ou Angular peuvent parfois offrir une flexibilité et des performances supérieures. De plus, pour des projets exclusivement mobiles ou des applications en temps réel exigeant une gestion fine du front-end, l’abstraction proposée par Symfony UX peut limiter certaines optimisations. Enfin, si une équipe dispose déjà d’une expertise avancée dans un autre écosystème front-end, il peut être préférable de rester sur ces technologies pour maximiser l’efficacité et la rapidité de développement.

Conclusion

Développer un projet avec Symfony UX offre de nombreux avantages : amélioration de la productivité, expérience utilisateur optimisée, très bon niveau de sécurité ou bien encore une maintenance simplifiée. Ainsi, Symfony UX se présente comme une très bonne solution pour développer votre application web. Que ce soit pour des projets d’envergure ou des applications nécessitant une évolution constante, Symfony UX offre un cadre de travail flexible et pérenne, capable d’accompagner les entreprises dans leur transformation digitale.

Pour résumer, Symfony UX représente bien plus qu’un simple ensemble d’outils : il incarne une véritable philosophie de développement qui prône la simplicité, l’efficacité et l’excellence. Un bon concurrent pour Laravel Nova ?

Une question ? C’est par ici !